A Dataprev (Empresa de Tecnologia e Informações da Previdência), vinculada ao governo federal, anunciou no mês passado um programa piloto em que brasileiros poderão vender seus dados pessoais e lucrar com isso. O projeto funciona em parceria com a empresa privada DrumWave, da Califórnia.

A lógica é simples: indivíduos já disponibilizam seus dados para diversas empresas sem receber nada por isso. Com o projeto, os brasileiros podem decidir se querem ou não ceder suas informações pessoais. E se optarem por ceder, receberão por isso.

A iniciativa foi anunciada durante o Rio Web Summit e é a primeira deste tipo a nível nacional no mundo inteiro. A esperança dos envolvidos é que o programa vá para frente por se tratar de uma parceria público-privada.

Piloto vai deixar brasileiros venderem dados pessoais

Desde 2023, um projeto de lei classifica dados como propriedade pessoal, permitindo que cada pessoa decida o que quer fazer com eles. Isso é bem comum na internet, onde usuários liberam acesso a informações pessoais através de formulários, cookies e outras permissões de sites.

O piloto anunciado no mês passado é uma parceria entre a Dataprev, empresa estatal que fornece soluções de tecnologia para o governo, e a empresa de monetização de dados DrumWave. O objetivo é deixar que os próprios brasileiros gerenciem seus dados, podendo vendê-los, se quiserem.

Inicialmente, o programa está sendo testado com um grupo selecionado de pessoas, que usarão uma carteira de dados chamada dWallet para pedir empréstimos consignados. Quando eles solicitarem novos empréstimos, os dados serão coletados pelas carteiras, em uma espécie de “poupança de dados”. Eles ficam armazenados e as empresas podem fazer ofertas para comprar essas informações.

Segundo o site Rest of World, funciona como cookies na internet. Só que, nesse caso, se o usuário aceitar ceder os dados, recebe por isso. O pagamento é creditado na própria carteira e pode ser transferido para uma conta bancária.

Para que serve o projeto de venda de dados?

Brittany Kaiser, cofundadora da Own Your Data Foundation e consultora do conselho da DrumWave, afirmou ao site que, atualmente, “as pessoas não ganham nada com os dados que compartilham”. A iniciativa as recompensaria por isso.

Para Kaiser, seria uma forma de inserir as pessoas no mercado de dados, que movimenta bilhões por ano, com expectativa de crescimento no futuro. No entanto, por ora, pessoas ‘físicas’ não participam disso.

Rodrigo Assumpção, presidente da Dataprev, também defendeu o piloto em comunicado em abril. Para ele, essa iniciativa pode “lançar as bases para um modelo de propriedade de dados que promova a inclusão financeira e redefina a economia digital sob uma perspectiva mais justa”.

Vender dados pessoais é recomendável? Especialistas têm dúvidas

Especialistas em proteção de dados no Brasil chamaram atenção para algumas preocupações ligadas ao projeto:

- A venda de dados tornaria essas informações pessoais uma espécie de commodity, podendo, inclusive, elevar o preço desses ativos;

- Isso tornaria os dados inacessíveis para empresas menores e até órgãos do governo com orçamento reduzido;

- O projeto também poderia aumentar a exclusão digital do país, afetando principalmente pessoas em situação de vulnerabilidade.

Quem chamou atenção para essa última hipótese foi Pedro Bastos, pesquisador da Data Privacy Brasil:

Vamos pedir para metade do país que não sabe ler decidir se seus dados podem ser comprados mediante uma determinada taxa. Pessoas em situação de vulnerabilidade dirão que sim, e isso poderá ser usado contra elas.

Pedro Bastos, pesquisador da Data Privacy Brasil, ao Rest of World

Leia mais:

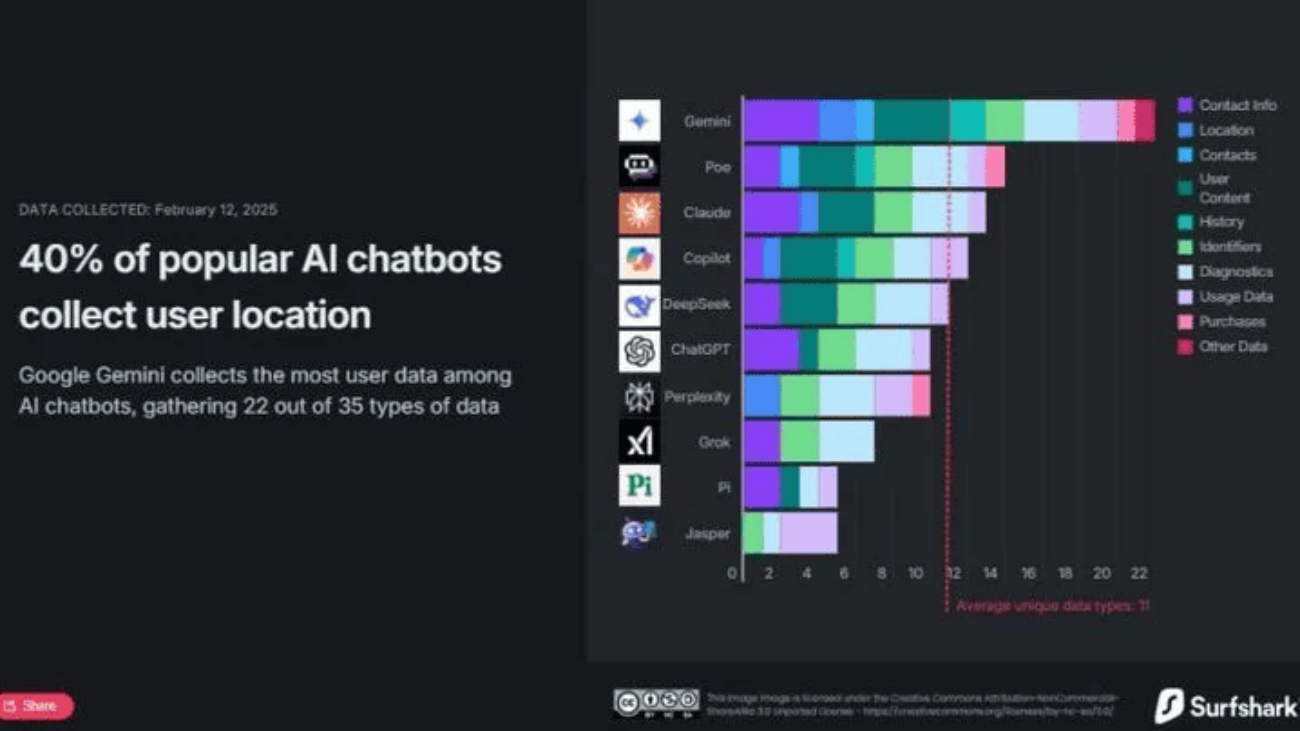

- Empresas estariam vendendo dados cerebrais de usuários; entenda

- Pagamento por escaneamento de íris: serviço é lançado oficialmente

- Receita Federal lança ferramenta para proteger CPF; veja como acessar

E no resto do mundo?

- Projetos de venda de dados já apareceram em outros países, como nos Estados Unidos. No entanto, por lá, a ideia não chegou a decolar no governo.

- No Oriente Médio, Arábia Saudita e Emirados Árabes Unidos criaram sua própria infraestrutura de comercialização de dados, apoiada pelo governo;

- Já na China, empresas podem tratar dados como ativos;

- Aqui no Brasil, a esperança é que o projeto vá para frente por se tratar de uma parceira público-privada.

O post Você faria? Brasileiros poderão ganhar dinheiro vendendo dados pessoais apareceu primeiro em Olhar Digital.

Cart is empty

Cart is empty